SEO でよく語られるサイトマップは、一般的には www.example.com/sitemap.xml などのように保存されて公開される、XML やテキストファイルなどの形式で記述されたページ一覧ファイルです。

ここでは、通常の Web ページ上で人間が見る「サイトマップ」と区別するため、検索エンジン等向けで人間が直接読むことを想定しない HTML ではないサイトマップを「XML サイトマップ」として呼称します。

一般的には XML サイトマップは SEO のベストプラクティスとして扱われています。しかしそれは正しい認識ではありません。必ずしも全ての環境でのベストプラクティスではないのです。XML サイトマップを無配慮に公開することは、SEO 上のデメリットになりえます。

実際、私たちが特定サイトの SEO のアドバイスに入る際、既に公開されている XML サイトマップを撤去していただくことが少なくありません。そして多くの場合ではそれによってサイトの検索性は改善されます。

どのような場合に XML サイトマップは有効で、どのような場合でリスクとなるのでしょうか?

この記事では、 XML サイトマップを SEO に使うべきでは無いケースについて説明します。

(株式会社JADE 辻正浩)

Google の説明する XML サイトマップの必要性

Google は、そのヘルプセンターの中で「次の場合は、サイトマップは必要ありません。」として下記のように記載しています。

- サイトのサイズが「小さい」。

- シンプルなサイト ホスティング サービスを利用している

- サイトはサイト内で完全にリンクされている

- インデックスに表示する必要のあるメディア ファイル (動画、画像)またはニュースページが多くない。

この説明に沿いますと、非常に多くのサイトは XML サイトマップが不要ということになるでしょう。

私はこのアドバイスに同意します。確かに Google が不要と説明するようなサイトで XML サイトマップを導入したことで明確に Google の SEO でプラスとなった事例はここ数年は確認していません。

数年前でしたら十分に価値はあり得ることでしたが、検索エンジンの性能が進化したいまでは、世の中の多くのサイトでは設置を行う必要はないのです。

では、こちらに該当しないサイトではどうでしょうか。私はそのようなケースでも XML サイトマップを活用するべきケースは珍しいと考えます。

このように私が考える理由を説明するために、XML サイトマップの効果から考えていきましょう。

XML サイトマップの SEO の効果

XML サイトマップは SEO に効果を持ちます。それは確かな事です。

私が Google の SEO で実際に確認している効果は下記です。

Googlebot クロールの推薦

XML サイトマップには特定ページが検索されるようになる(以後「indexされる」といいます)の早期化・安定化の効果があります。これが最大のメリットとして見られる場合が多いでしょう。

確かに XML サイトマップ記載 URL は、未記載 URL よりも Googlebot の訪問が早く、多い傾向があります。サイトによっては通常では index されるまで数時間~数日かかるページでも、XML サイトマップを適切な形で導入することで数十秒~数分で index される場合もあります。また <lastmod> の適切な設定で、大規模なサイトにおいては更新された情報を早々に検索エンジンに認識させることも可能です。

「公開したページを一刻も早く index させたい場合」「毎日大量にページを公開している巨大サイトで何もしないと新規 URL を検索エンジンに発見されづらい場合」などでは XML サイトマップは有効な場合も多いです。

クロール動線の無い URL を index されるようにする

Google など検索エンジンは、基本的に他ページからのリンクをたどって未発見 URL を発見します。ただサイトの要件上、どうしても検索エンジンが辿れるようなリンクを配置できない場合があります。

XML サイトマップには、そういうケースでもページを index させる効果があります。

重複コンテンツ発生時の正規 URL の推薦

同じ内容のページは通常の Web 運営においても発生するものですが、検索エンジンはそのうち一つだけを評価対象として、残りを検索結果から除外するようにしています。いわゆる重複コンテンツです。その評価対象とするべき主な URL、正規 URL を発見するために検索エンジンは様々な情報を参考にします。そのうちの一つの評価基準として XML サイトマップが使われています。

正しく XML サイトマップを記載することで、重複コンテンツにより発生するリスクを軽減することができます。

特殊なページの認識

XML サイトマップには URL の場所のみではなく様々な情報を付与できます。それによって、多言語・多地域向け情報、ニュース記事、動画、画像など特殊な情報を検索エンジンに正しく伝えることができます。

XML サイトマップの SEO 上のリスク

これまで記載してきました通り、XML サイトマップは明らかに SEO 上の効果を持つものです。

しかし効果があることは、検索エンジンに影響を与えているということです。その影響によっては必ずしもプラスに限定されません。

前項で説明した利点は、そのままリスクになり得るのです。

Googlebot クロールの推薦→クロールの偏りに繋がる

検索エンジンは非常に高度なアルゴリズムでどの URL をクロールするか決定しています。XML サイトマップは、その高度なアルゴリズムに対して影響を及ぼすものです。

特に巨大サイト、毎日何千何万というページが新規公開・更新されるページの場合、Google が非常に高度なアルゴリズムでそのクロールの順番を決め、サイトを上手く認識しています。

もともとの高度なアルゴリズムでほとんどのページを回れていた場合でも、XML サイトマップが公開され記載されたURLが優先されるようになると、XML サイトマップに記載されない URL はいつまでもクロールされなくなる、ということも発生します。

実例を挙げましょう。

とある巨大サイトでは、XML サイトマップには複数ページからなる一覧ページの1ページ目だけを XML サイトマップに記載していました。これはよくあることです。一覧ページが何ページまで存在しているかを計算して XML サイトマップに最終ページまで記載する、ということは若干のリソースを必要としますので省略するのはよくあることでしょう。

そのようにした場合、Googlebotは明らかに1ページ目を優先して何度も何度もクロールします。通常でも1ページ目は優先されがちですが、XML サイトマップでの推薦も加わるとその傾向は更に強化されるのです。

1ページ目を定期クロールするだけではタイミングが合わず、全 URL を発見できないような Web サイトもあります。そこで1ページ目のクロールが優先されることで新規ページが発見されない問題を引き起こします。

これは、数百~数千ページ規模のサイトや更新されるページが少ないサイトでは問題となりません。しかし、検索エンジンが全てのページを早期に回りきれないようなサイトでは明らかな問題になりえるのです。

クロール動線の無い URL をインデックス化→評価されない URL を放置することに

クロール動線の無い URL を検索エンジンに伝え、index させることは XML サイトマップの効果です。

それは、どこからもリンクされていないページを検索対象にするということです。これは問題にもなりえます。

Google の重要なアルゴリズム、PageRank は内部リンクでも影響します。内部リンクを適切な形で張った場合、そのリンク先は検索として評価されやすくなります。その影響は10年程前のように絶大なものではありませんが、2020年のいまでも十分に効果があります。Google が認識できる形で内部リンクを張ることは、リンク先のページの評価に繋がります。

もし検索対象としたいものの Google に index されていないページを発見した場合、そのページへの内部リンクを検索エンジンが十分な形で評価していない場合がほとんどです。その状態ではそのページの評価は上がりきりません。

そのような URL を発見した場合、内部動線などを見直す事でそのページに記載された情報は検索されやすくなり、検索流入の向上に繋げることができます。index されていないページを発見する事は、サイト構造の問題点を把握して改善に繋げられる数少ない機会なのです。

しかし XML サイトマップを記載していた場合は、本来そのページに価値を与えるリンクが無い状態でも検索対象としてしまいます。そのページは検索競合が存在しない検索語句での流入を取れる場合もあります。ただ一般的なキーワードでは上位表示は困難です。

通常では index されないページを XML サイトマップで無理やり index させる事は、評価されないページを増やす結果につながる場合があります。そして、その改善の糸口もわかりづらくしてしまうのです。

サイトの仕様上、どうしても検索エンジンが評価する形でリンクを配置できないならば、XML サイトマップに頼る選択肢もあるかもしれません。ただ、それではあまり検索流入を得られません。

あなたの Web サイトが XML サイトマップに頼って index させているならば、まずはサイト改善をするべきでしょう。

重複コンテンツ発生時の正規 URL の推薦→誤った記載により致命的な問題になりえる

先にも記載しましたとおり、検索エンジンは重複コンテンツを発見するために様々な内容を利用します。その評価基準の一つとなる XML サイトマップに正しく正規URLを記載することで、より望ましい形でページを検索エンジンに認識させることができるでしょう。

ただ、それは正しく記載した場合だけです。もし、XML サイトマップに誤って非正規 URL を記載してしまったのならば大きな逆効果になる可能性があります。

たとえば、本来の内部リンクを集中した正規URLは 「/」で止めていたにも関わらず、XML サイトマップ記載URLを 「/index.html」を加えてしまった場合を考えましょう。

多くの場合、Google は様々な評価基準で XML サイトマップを無視して「/」 を正規 URLとします。しかし一部の場合では XML サイトマップの推薦を重視して 「/index.html」 を正規URLとします。それはそのページがしばらくの間、適正な価値を評価されない事になります。

XML の記載ミスで正規化が混乱されるのはよくあることではありません。しかし、1%などの確率では発生すると考えます。1万 URL あった場合は 100 URL もの情報が検索されづらいページが発生することになります。

また、正規化の問題以外にも、このようなケースも想定されます。

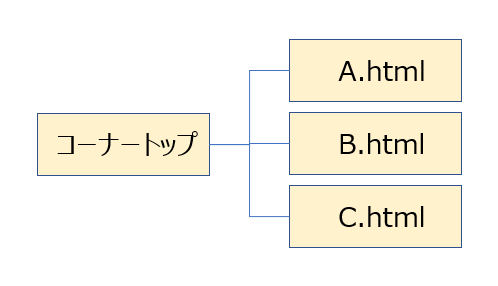

このように、1つのコーナーに 3 URL が存在している状態があり、この段階で XML サイトマップを作成したとします。

その後、ページを追加してこのようになりました。

XML サイトマップ生成をシステム化せず、手作業で作っているようなケースではよくある動きになります。しかしこの状態はサイトの状態によっては問題になります。

この状態では、A、B、C ページは XML サイトマップに記載され、D ページは記載されません。このとき、もし C ページと D ページの内容が似通っている場合。D ページは index されづらくなります。

このような事は ABCD ページが一般的な記事ページでしたら滅多に発生しません。ただこの ABCD ページが動画や画像を主体としたページで、テキスト情報が少ないようなページだった場合などでは、問題は頻繁に発生します。

サイトの一部しか XML サイトマップに記載されていない場合、XML サイトマップの重複コンテンツを判定する効果は逆効果になりえるのです。

さらにこのような状態では、先述した「クロールの偏り」の問題があり、なかなかD.html にクローラが訪問しづらい状況も生みます。新規ページへのクローラ訪問が遅延する状態が、本来クロールを促進する役割の XML サイトマップにより発生するのです。

特殊なページの認識→大きなリスクは無い

このメリットについては大きなリスクはありません。該当するコンテンツを主にしたサイトは XML サイトマップを採用するべきです。ただ、影響力が強いため誤ると大きな問題になることは確かです。

XML サイトマップが不要なサイトと必要なサイト

ここまで述べてきましたように、XML サイトマップには大きな影響力があります。その影響力は、プラスにもマイナスにも働くものです。XML サイトマップの挙動を把握せずに使うことは大きなリスクでしかありません。完璧ではない XML サイトマップの公開はリスクを伴います。

もし、適切なタイミングで更新される、サイトの内容を全て網羅した XML サイトマップを公開できるならば問題無いでしょう。最低でもマイナスはありません。

WordPress や(私も開発に関わっております)はてなブログなど安定した XML サイトマップ生成システムが備わっているサービスでは、XML サイトマップを公開したままにすることでマイナスはありません。

ただ、完璧な内容を作ることができないのであれば、XML サイトマップ公開を控えることを私はおすすめします。

不完全な XML サイトマップしか作成できない場合はリスクがあります。不完全な XML サイトマップが検索エンジンに伝えられる情報は不完全です。不完全な情報を伝えられた検索エンジンがどのような挙動をするかは予想が難しいものです。

特に、冒頭で記述しました Google が指摘する「サイトマップは必要ありません」と言われる所にも関わらず誤った XML サイトマップを掲載することで、余計なリスクを抱えた Web サイトも存在しています。

いわゆる「蛇足」です。XML サイトマップは蛇足になりがちなのです。

XML サイトマップが必要なサイト

ただし、XML サイトマップが必要なサイトも存在します。

- 巨大サイトで毎日数千~数万以上の URL が更新され通常の方法では検索対象にならないページがあり、通常のサイト改善では index させられないサイト

- 画像、動画、ニュース、多言語など、XML で検索エンジンに伝えるべき特殊な情報を多く持つサイト

- Bing や百度、Yandex などのように XML サイトマップが無いと index の問題が起きがちな検索エンジンからの集客が必要なサイト

などが挙げられます。

この場合は XML サイトマップの導入を考える必要があります。そのときは完璧な XML サイトマップを目指すのが望ましいです。

しかし、巨大サイトにおいては完璧な XML サイトマップを作ることは現実的ではないほど困難な場合も多いです。巨大サイトで完璧な XML サイトマップを運用できている Web サイトは見たことがありません。

XML サイトマップが必要、だが完璧なものはつくれない。そのような場合にはどうするべきでしょうか。?

わたしは、リスクを把握するために最大限の努力をするしかないと考えます。

各ページの index 状況や Googlebot ログ精査を定期的に行い、XML サイトマップの不完全な部分がクロールに悪影響を与えていないか挙動の変化をしっかりと把握すべきでしょう。

SEO とベストプラクティス

この記事で説明してきましたことをまとめます。

- 小規模な Web サイト、正しいサイト設計の Web サイトなどの大半では XML サイトマップは不要

- 一部の XML サイトマップが必要な Web サイトでも、誤っていたり、更新しない XML サイトマップを公開するなら無いほうが良い場合が多い

冒頭で申しました通り「サイトマップは SEO でのベストプラクティス」と非常によく語られています。しかし今回説明しました通り「Google は公式に多くのサイトにサイトマップは不要と説明」しており「実際にリスクも存在する」ものです。決して XML サイトマップは SEO のベストプラクティスではありません。

そして、XML サイトマップ以外でも語られる SEO のベストプラクティスもそのほとんどは多くのサイトでは不要なものであったり、リスクを持っているものです。

SEO には、さまざまな「ベストプラクティス」が存在します。しかしどのようなサイトにも共通するベストプラクティスは「良いコンテンツを作る」「良い title を作る」など SEO 観点ではなくとも良い Web サイトを作る上で当然の事しかありません。

一般的なシンプルなサイトには XML サイトマップも不要ですし、共通のベストプラクティス以外に細かいテクニックはどんどん不要になってきています。

ただ、一般的ではない複雑なサイトにとっては、そしてこの共通ベストプラクティスだけで必ずしも適切にサイトが検索されるようにはなりません。そのようなサイトでは、様々な試行錯誤が必要です。それはベストプラクティスをなぞることだけでは達成できない場合が多いでしょう。

あなたのサイトにあったベストプラクティス選択を考えてみて下さい。