多くのSEO担当者がGoogle Search Consoleや GA4の基本機能を使っています。しかし複雑な運用で幅広いデータ分析が必要になると、これらのツールだけでは太刀打ちできないと感じる場面が増えているのではないでしょうか? SEOは個別のキーワードの最適化から、ユーザージャーニー全体を見据えた総合的な分析へと変化しているからです。この変化に対応するには標準ツールでは見えないデータを分析できる環境が必要です。この変化に対応したチームは先行しますし、そうでないチームは不完全なデータで意思決定を続けることになります。

この記事を読んでいただくと、こんなことがわかります

💡Search ConsoleやGA4の限界がなぜ起きるのかを理解できる

💡検索クエリの80%が見えない現実を知ることができる

💡キーワード単体ではなくユーザーの行動全体を考える方法を学べる

そんな課題感から、先日「SEO Data Unlocked」という共催ウェビナーを国内外のパートナーと開催しました。JADEファウンダーの長山一石が、ユーザーの検索ジャーニー全体を分析する「検索インタラクションモデル」のフレームワークを紹介。大規模ECの国際SEOを担当するATP Autoteile(ATPアウトタイレ)のEyüp Alikilic(エユップ・アリキリチ)氏が、実際のデータ分析手法を実演しました。モデレーターはDemandSphereのRay Grieselhuber(レイ・グリセルフーバー)さんが務めてくれました。

この記事では、全編英語のこのウェビナーで話された内容をベースにしています。いまのSEOツールが抱えている課題と、それを乗り越えるアプローチについて日本語でまとめました。

検索は「一回だけの取引」ではなく「会話」である

まず、長山がウェビナーで強調したのは「検索を一回だけの取引として考えるのをやめましょう。会話として考え始めてください」ということでした。「そして、すべての検索を大きなストーリーの中の一つの質問として捉えてください」。

たとえば、今度アジアに旅行に行こうと考えている人がいるとします。その人の検索行動は、こんな流れになるのではないでしょうか。

- 最初は「アジア おすすめ 国」

- 日本に興味を持ったら「日本 おすすめ 都市」

- 京都が気になって「京都 ホテル」

- さらに深堀りを開始して「京都 日帰り旅行」

これらは独立した検索ではなく、つながった会話の流れです。ユーザーは検索エンジンと対話しながら、自分の知りたいことを段階的に明確にしていきます。

従来のSEOには、見直すべき前提があります。「京都 ホテル」で1位をとろう、「日本 おすすめ 都市」で上位表示を狙おうという、ユーザーが個別のキーワードを独立して検索するという考え方です。この考え方だと、ユーザーの「旅の計画」をサポートするという大きなチャンスを逃しています。実際の検索行動はつながったパターンなのに、キーワード中心のアプローチでは断片的なユーザー体験しか生み出せません。エンゲージメントの可能性は大きく制限されてしまいます。

JADEが提唱する検索インタラクションモデルは、個別のキーワード対応ではなく、ユーザーのストーリー全体、検索ジャーニー全体に焦点を当てています。このフレームワークでは、それぞれの検索をユーザーが進めている大きなストーリーの一部として扱い、コンテンツをその案内役として位置づけています。

【検索インタラクションモデルについてはこちらです】

ただし、ジャーニー重視の最適化を大規模に実装するには、ユーザー行動パターン、クエリの関係性、コンテンツパフォーマンスといったデータすべてが必要です。従来のSEOツールだけでは、ここに限界があります。続いてATP AutoteileのEyüp氏(以下エユップ)のパートでは、その現実を事例で示してくれました。

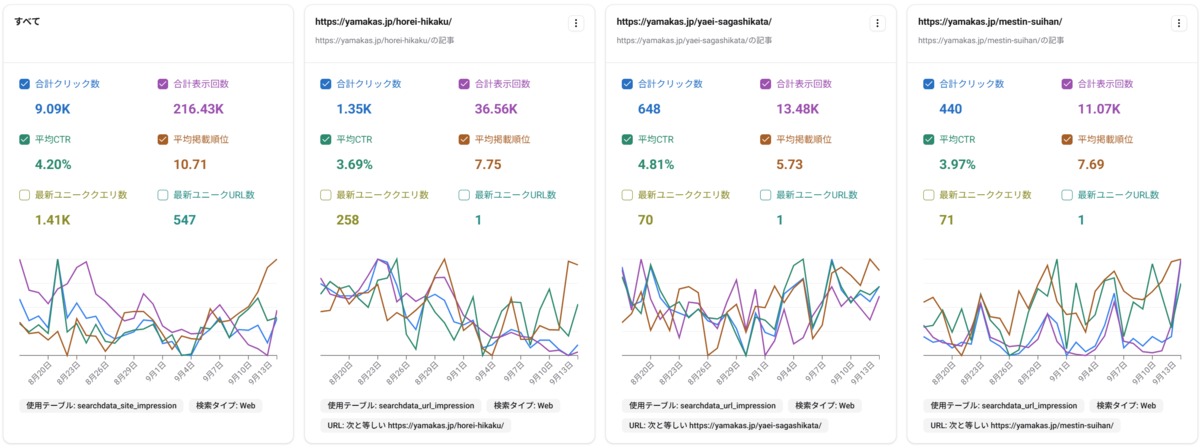

データの80%が見えない状況

エユップ氏のプレゼンは、驚きと学びに溢れていました。

大規模ECサイトのSEOを世界規模で管理するエユップ氏。プレゼンでは、規模が大きくなると標準ツールでは対応しきれなくなる現実を見せてくれました。まずは彼が管理するサイトの規模感について。

- 10,000以上のURLをトラッキング

- 複数市場で10,000以上のキーワードをターゲティング

- ロングテールでツールの処理能力を超えるクエリ数

- 国をまたいだパフォーマンス分析

この規模になると、標準ツールだけでは限界があります。多くのSEO担当者は自分のツールで十分だと考えていますが、実際はそうではありません。ジャーニー重視の最適化には、ユーザー行動の全体像を捉える幅広いデータが必要です。

そしてエユップ氏は「ATP Autoteileの検索クエリの80%は、Googleによって匿名化されている」という現実を共有してくれました。

ユーザーがどうコンテンツを見つけ、関わっているか。その大部分が見えない状況では、戦略的な判断が非常に難しいでしょう。

「幅広い商品ラインナップで国際展開していると」とエユップ氏は説明します。「ロングテール領域での戦いになり、戦略もそこにシフトする必要があります」。

まずは適切な質問をすることから

データ分析に取り組む前に、エユップ氏は強調していたのは基本的でいて、しかし重要なことでした。

「良い分析は良い質問から始まります。まず適切な質問を準備する必要があります」

分析結果からどんな行動が取れるか、最初に決めておくということです。「すべてのデータを可視化しても意味がありません」とエユップ氏。「具体的な質問が必要です。データで何を解決したいのか」

戦略的な問題なのか、運用上の問題なのか。どのくらいの頻度で分析が必要なのか。こうしたことを決めておく必要があります。

「テーブルリファレンスを調べる前に、適切な質問から始めてください」とエユップ氏。「データ量は膨大だし、問題とその解決方法に優先順位をつけなければならないからです」。このアプローチで、大量のデータに圧倒されることを防いでいます。

高度な分析で見えてくるもの

標準ツールと高度なデータ分析の違いは、実際の事例で明らかになります。

事例1

2024年のバレンタインデーに、エユップ氏のチームはトラフィック指標の急降下を目にしました。普通の組織なら「何か問題が起きた!」と慌ててミーティングが始まるところです。

でも、エユップ氏はダッシュボードを開いて笑います。「当然ですね。バレンタインデーに自動車部品を買う人はいませんから」

エユップ氏が独自に構築した分析基盤では、これが通常の季節変動だとすぐにわかりました。標準ツールでも数値の下降は見えますが、それが想定内かどうかを判断する過去データがありません。

事例2

トラフィックが複数カテゴリで突然下がった時も、エユップ氏のBigQueryダッシュボードが威力を発揮しました。どのコンテンツエリアが影響を受けているか、いつから始まったかが瞬時に特定できたので、すぐにデプロイを戻せました。

「多くのセグメントでトラフィックが止まったので」とエユップ氏。「デプロイを戻したら、すぐにこれらのURLがトラフィックを取り戻し始めました」。どのコンテンツが影響を受けたか正確に把握できたので、ピンポイントで対応できたのです。

エユップ氏のチームは27の異なるページセグメントを日常的にトラッキングしています。最近クリックがないページから、多様なキーワードでトラフィックを獲得するURLまで。この体系的なトラッキングは、標準ツールの限界を超えた分析を可能にしています。

可視化ツールの限界

ここまで見てきた高度な分析は、どんなツールで実現しているのでしょうか?

長山もエユップ氏も、最初は王道の選択肢から始めました。BigQueryエクスポートに接続されたLooker Studioです。しかし、2人ともこのソリューションには問題があると言います。

「Looker Studioはすぐに遅くなります」と長山。「世界規模で数百万の検索クエリを分析する際、動作が重すぎて分析のリズムが完全に崩れてしまうんです」

エユップ氏は技術的な観点から複雑さを指摘しました。「美しいグラフの裏にあるクエリをどう維持するか、考え出す必要があります。技術的な知識、特にツールの知識が必要です。何をしているか注意しないと、一回のクリックで大量のデータをスキャンすることになりかねません」

幅広い検索データを持つことと、それを戦略的判断に活かすことの間には、大きなハードルがあります。

Amethyst が解決する課題

この課題は特定の企業だけの問題ではありません。高度なSEOが要求するデータの洗練度に、ツールが追いついていないという業界全体の問題です。

「もっと高速で直感的に使えるものを作りたかった」と長山は説明しました。「Looker Studioはあらゆるデータに対応しなければならないため、どうしても使いにくくなってしまうからです」

この課題に対処するため、Amethyst はスピードとSEO特化のワークフローに焦点を当てました。積極的なバックエンドキャッシュで分析を中断するクエリの遅延を排除し、汎用的なビジネスインテリジェンスではなく、検索データに特化したインターフェースを提供しています。

Search Console、GA4、URL検査APIのデータと、AIによるクエリ・URLグルーピングの提案を組み合わせることで、Amethyst は総合的な検索インテリジェンスを特別なプロジェクトだけでなく、日常的な戦略判断でも使えるようにしました。

今後の展望:AI検索とデータの進化

ウェビナーが進む中で、会話は自然にAI検索とそのデータ分析への影響に向かいました。

長山はAI検索機能がデータの利用可能性に与える影響を説明しました。「AIモードでは、検索はより会話的で長い文章になります。こうした自然言語クエリは以前から存在していましたが、非常に長く、時には個人的な内容であるため、データセットに入ってこない傾向があります」

懸念は現実的なものです。「私たちはデータに大きく依存しています」と長山。「Googleの検索チームがAI OverviewsとAIモードのクエリをBigQueryデータセットで利用可能にするかどうかを決める必要があります。そうでなければ、匿名化されたクエリは増加し続けるでしょう」

データドリブンSEOの未来へ

今回のウェビナーでは、SEOが標準ツールでサポートできる範囲を超えて進化していることが改めて確認されました。幅広い検索データを持つことと、それを戦略判断に実際に活かすことの間のギャップは、個別キーワードではなくユーザージャーニー全体の最適化を目指すチームにとって現実的な課題です。

異なるマーケットのSEO担当者が、標準的なアプローチを超えて拡大する際に、類似した課題に直面していることも明らかになりました。それぞれが工夫しながら、より良い分析環境を作ろうとしています。SEOの未来は、データをより深く理解し、それを日々の判断に活かせるツールをどう使いこなすかにかかっているのかもしれません。

ウェビナーで貴重な知見を共有してくださった講演者の皆さん、活発な質疑応答をしてくださった参加者の皆さん、本当にありがとうございました。

【JADEのウェビナーアーカイブ、適宜追加中です】